ノートブック開発

ノートブックをフルで使うには、ms-toolsai が公開してる Jupyter(id: ms-toolsai.jupyter)拡張機能をダウンロードしてね。

.ipynb と .py の両方に対応してる。Tab、Inline Edit、Agents は、

ほかのコードファイルと同じようにノートブック内でも動くよ。

主な機能:

- インラインでのセル実行 により、エディター内でそのままコードを実行できる

- Tab、Inline Edit、Agent は、pandas、NumPy、scikit-learn、SQL マジックコマンドなどのデータサイエンス系ライブラリを理解してる

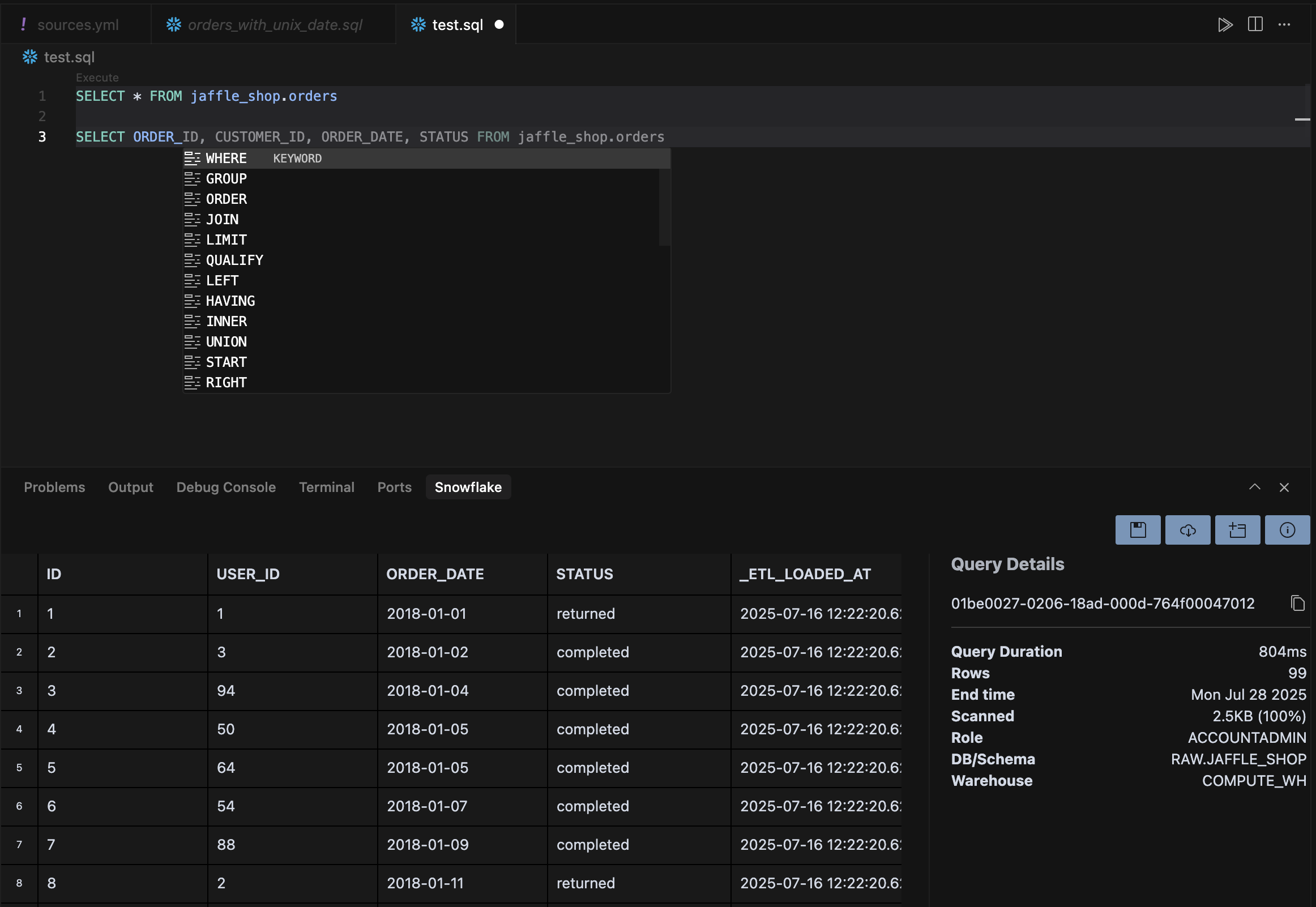

データベース統合

- MCP Servers はエージェントがデータベースに接続できるようにする

- Extensions は IDE 全体をデータベースと統合する

MCP 経由

Extensions 経由

データ可視化

よくある質問

.ipynb ファイルを開いて、セルの実行と AI 補完をフルサポートしてるよ。

メモリに収まらない大規模データセットはどう扱えばいい?

Dask みたいな分散処理ライブラリを使うか、Remote-SSH でより大きいマシン上の Spark クラスターに接続してね。

Cursor は R と SQL ファイルに対応してる?

うん、Cursor は R スクリプト(.R)と SQL ファイル(.sql)に対して、AI アシストとシンタックスハイライトを提供してるよ。

開発環境を共有するおすすめの方法は?

.devcontainer フォルダをバージョン管理にコミットして。プロジェクトを開いたときに、チームメンバーが自動で環境を再構築できるよ。

データ処理パイプラインはどうやってデバッグするの?

Cursor の統合デバッガで Python スクリプトにブレークポイントを置くか、Agent を使って複雑なデータ変換をステップごとに解析・解説してもらおう。

環境の再現性

開発コンテナ

.devcontainer フォルダを作成しよう。次に devcontainer.json、Dockerfile、requirements.txt を用意してね。

Reopen in Container を検索して、手動でコンテナ内に再オープンしてもOK。

開発コンテナの主なメリット:

- 依存関係の分離 により、プロジェクト間の競合を防ぐ

- 再現可能なビルド で、開発・本番を問わず一貫した動作を保証

- オンボーディングの簡素化 により、新メンバーが手動セットアップなしですぐに始められる

SSH を使ったリモート開発

- 必要なリソースを備えたクラウドインスタンスを用意するか、オンプレミスのサーバーにアクセスする

.devcontainer設定を含めて、リポジトリをリモートマシンにクローンする- Cursor から接続: Ctrl+Shift+P → “Remote-SSH: Connect to Host”